Unmanned Aircraft Systems (UAS, ugs. Drohnen) werden inzwischen auch von landwirtschaftlichen Dienstleistern und Landwirten für

verschiedene Aufgabenbereiche genutzt. Vor allem Betriebe mit einer Größe von mehr als 100 ha setzen auf Drohnen zur Wildrettung,

zum Monitoring von Pflanzen und Böden sowie zur Pflanzenschutzapplikation und Ausbringung von Nützlingen. Die Etablierung von

Drohnen in der Landwirtschaft setzt sich auch insbesondere im Feldversuchswesen fort – Stichwort „Phenotyping“. Viele

Lösungen am Markt sind allerdings nicht primär dafür entwickelt, was tiefgehende Evaluationen und weiterführende

Entwicklungen erforderlich macht.

Am LTZ Augustenberg wird deshalb im Rahmen des vom MLR geförderten Projekts “Entwicklung und Einführung von

drohnengestützten Analysenmethoden im Versuchswesen” der Einsatz von UAS erprobt und erweitert. Ziel des Vorhabens ist die

Evaluierung der Nutzung von Drohnendaten in der Landwirtschaft und insbesondere im Kontext des Feldversuchswesens.

Das Projekt startete im Jahr 2020 mit 2 Jahren Laufzeit als Anschub zum Testen des Einsatzes von UAS im Feldversuchswesen. Auch nach

Projektende werden UAS am LTZ eingesetzt und die Arbeitsgruppe Digitalisierung beschäftigt sich weiterhin mit der Entwicklung von

Bildauswerteverfahren und dem Einsatz neuer Kamerasysteme, beispielsweise hochaufgelösten Bilddaten und Themalinfrarot für das

landwirtschaftliche Versuchswesen des LTZ.

Am LTZ in Forchheim sind derzeit verschiedene UAS des Herstellers DJI im Einsatz. Dazu zählen zwei DJI Phantom 4 Drohnen, eine mit RGB-Kamera (P4R) ausgerüstet und eine mit einer multispektraler Kamera (P4M). Neu angeschafft wurde eine DJI Matrice 300 (M300) mit hochauflösender RGB Kamera. Die Drohnen sind alle mit RTK-GPS (real time kinematic global positioning system) ausgestattet und nutzen den SAPOS-Dienst des Landes Baden-Württemberg (SAPOS-BW). Zur Verstärkung des RTK-Positions-Signals in Bereichen ohne Mobilfunkabdeckung wurde eine RTK Basisstation angeschafft (DJI D-RTK 2). Aufgrund des großen Interesses an der Technik seitens anderer Sachgebiete/Referate wurde für den Standort Emmendingen ein weiteres multispektrales System beschafft, das ab 2022 dort im Einsatz sein wird. Außerdem wird ab 2022 im Sachgebiet Biodiversität unter anderem zur Detektion von Gelegen in Feldern eine weitere M300 mit Thermalinfrarotkamera erprobt.

Die Prozessierung und Analyse der UAS-Daten ist nicht mit den Computern, die üblicherweise in einer BK-Umgebung zu finden sind, möglich, weshalb für die Arbeitsgruppe Digitalisierung sowohl leistungsstarke Workstations beschafft wurden als auch leistungsfähige Notebooks für die Mitarbeiter, mit Zugriff auf die Rechenleistung dieser Workstations. Diese sind mit 128 GB Arbeitsspeicher, neuester Prozessortechnik und leistungsstarken Grafikkarten für parallelisierte Berechnungen (NVIDIA-CUDA) ausgestattet. Die neu geschaffene IT-Umgebung des Forschungsnetzes läuft unter Linux, Wartung und Systemadministration werden von der AG Digitalisierung selbst übernommen

Eine Befliegung wird anhand von Parametern wie der aufzunehmenden Fläche, der passenden Auflösung und Bildüberlappung

geplant, woraus sich eine Flugroute mit festgelegter Flughöhe und geschätzter Dauer der Mission ergeben.

Zunächst werden bei den Befliegungen Einzelbilder aufgenommen, in der Regel aus der Vogelperspektive senkrecht nach unten. Um aus

diesen Bildern eine Auswertungsgrundlage zu generieren sind verschiedene Prozessierungen erforderlich.

Bei Befliegungen durch die P4M werden die Einzelbilder zunächst aufeinander spektral referenziert, denn die Kamera verwendet für

jeden Spektralbereich einen eigenen Sensor. Die Bilder der einzelnen Sensoren für einen Zeitpunkt (5 Stück) müssen

radiometrisch aufeinander abgestimmt werden. Diese Korrektur erfolgt mit eigens entwickelten Prozessketten, die durch Skripte, d.h.

automatisierten Berechnungsvorschriften, pro Bild und pro Pixel die vorgegebenen Korrekturparameter anwenden. Für die P4R

entfällt dieser Ausgleich, da die Aufnahmen mit einem einzigen Sensor gemacht werden, der ähnlich wie eine handelsübliche

Digitalkamera funktioniert.

Die Einzelbilder werden anschließend mit photogrammetrischer Software zusammengefügt, aktuell sind Metashape, OpenDroneMap und

Pix4Dfields zum Einsatz. Dabei werden nach Auffinden gemeinsamer Punkte in den Überlappungsbereichen der Einzelaufnahmen alle

Einzelbilder zu einer Gesamtszene zusammengesetzt, die zunächst aus einer 3D Punktwolke besteht. Aus den Metadaten der Einzelbilder

wird zudem die RTK-GPS-Position der Drohne bei Bildaufnahme abgelesen, wodurch die Gesamtszene georeferenziert werden kann. Dadurch ist

jedem Punkt eine eindeutige Koordinate zugewiesen und räumliche Analysen in einem GIS (Geographisches Informationsystem) werden

möglich. Mit Hilfe photogrammetrischer Verfahren errechnet Metashape durch die verschiedenen Kamerapositionen zudem ein digitales

Höhenmodell.

Anhand des Höhenmodells wird in einem letzten Schritt eine geometrisch entzerrte Ansicht erstellt. Damit liefert die Vorprozessierung

ein georeferenziertes Gesamtbild, das sogenannte Orthofoto, und ein Höhenmodell. Im Projekt wurde ein Algorithmus entwickelt, um die

Vorprozessierung weitgehend automatisiert durchzuführen, wodurch manuelle Eingaben und Wartezeiten bei den vielen Zwischenschritten

entfallen

Für das Feldversuchswesen wurden bislang verschiedene Datenprodukte entwickelt, welche teilweise automatisiert berechnet werden können. Diese Produkte werden dann an die Versuchsansteller und -techniker weitergegeben und können in die Versuchsauswertungen miteinbezogen werden.

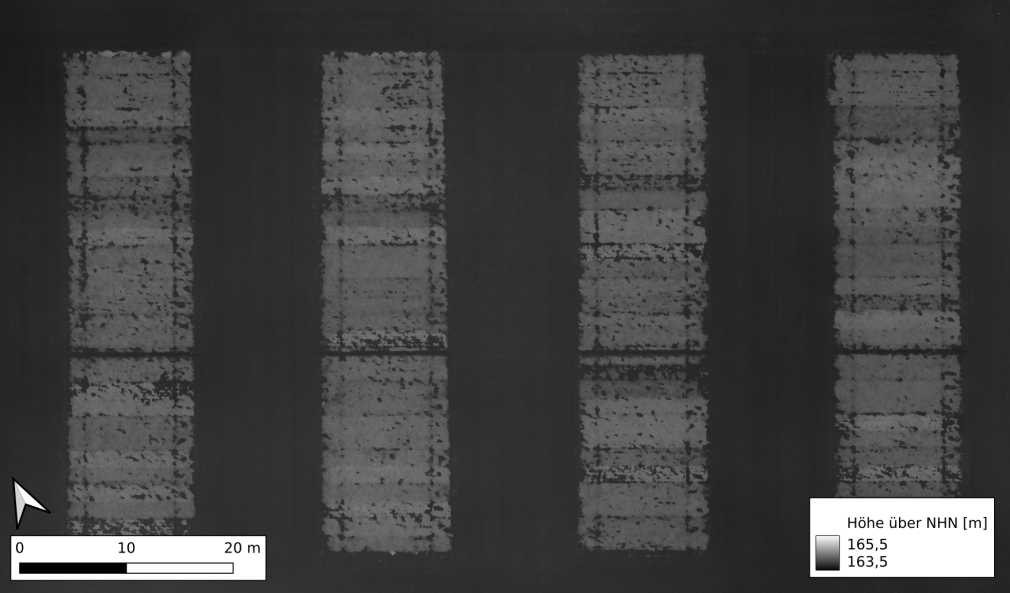

Orthophoto & Höhenmodell

Orthophoto und Höhenmodell der beflogenen Fläche werden im Rahmen der Vorprozessierung erstellt und können in gängigen

GIS Anwendungen betrachtet werden. Diese bilden außerdem die Grundlage für alle weiteren Auswertungen. Hieraus können auch

visuell Einschätzungen zu der Fläche getroffen werden, welche von einem Standpunkt am Boden nicht zu sehen sind oder nicht genau

genug verortet werden können, wie zum Beispiel Heterogenitäten der Fläche zur Positionierung von Versuchsparzellen.

Orthophoto des Kichererbsen-Sortenversuches 2020 (Markus Strathmann, AG Digitalisierung)

Höhenmodell des Kichererbsen-Sortenversuches 2020 (Markus Strathmann, AG Digitalisierung)

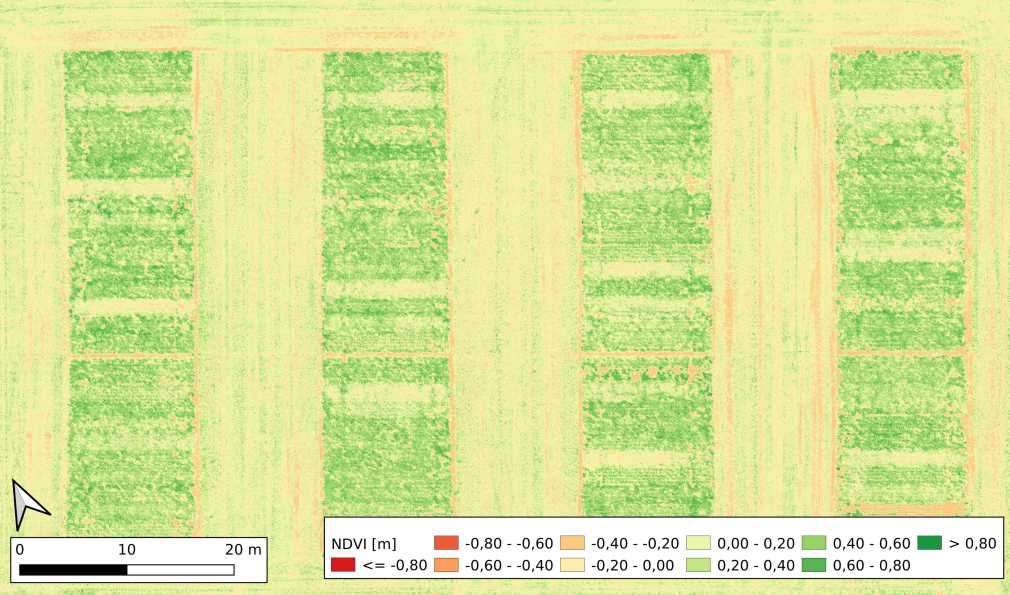

Vegetationsindizes

Aus den Orthophotos der Drohnen werden Vegetationsindizes abgeleitet. Diese bilden für jedes Pixel ein Verhältnis von aufgenommenen Kanälen zueinander ab. Ein Vegetationsindex kann einfachen Berechnungen folgen, z.B. dritter Kanel (Rot) geteilt durch fünften kanal (Nahinfrarot) und ergibt ein neues Bild. Besonders wichtig in der Landwirtschaft ist der NDVI (Normalized Difference Vegetation Index), der aus den multispektralen Daten der P4M errechnet werden kann, weil diese auch im Infrarotbereich aufnimmt. Der NDVI gibt Aufschluss über die Photosyntheseaktivität anhand der unterschiedlichen Reflexion von rotem und nahinfrarotem Licht grüner Pflanzenteile. Für RGB-Datensätze eignet sich der Excess Green Index (EGI), bei dem die Grünanteile im Bild verstärkt werden. Der EGI wird unter anderem zur automatisierten Klassifikation von Vegetation und Boden genutzt. Die Berechnung der Vegetationsindizes erfolgt nach entsprechender Methodik automatisiert.

NDVI berechnet aus dem Orthophoto des Kichererbsen-Sortenversuches 2020 (Markus Strathmann, AG Digitalisierung)

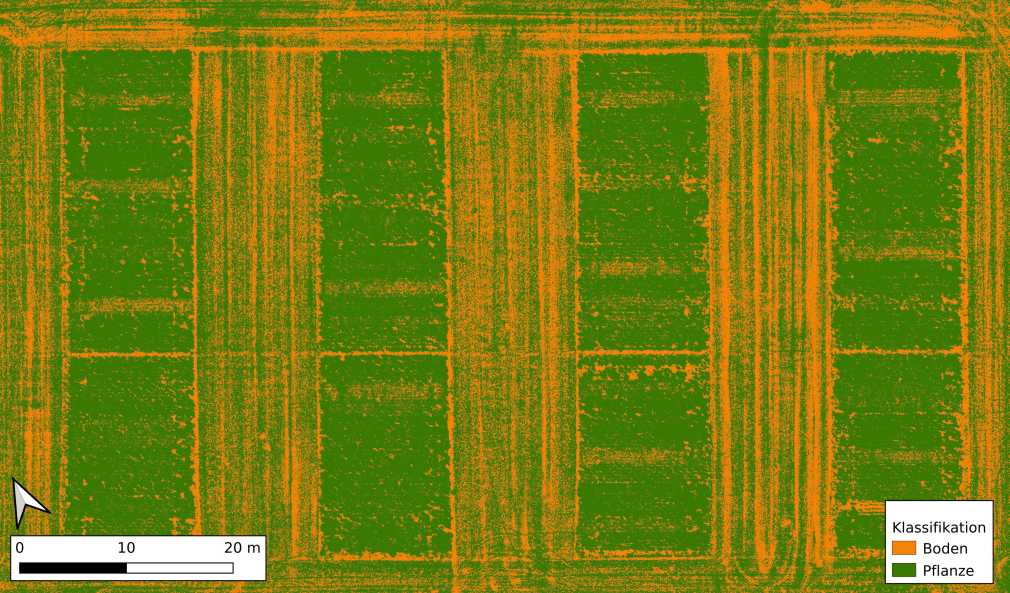

Klassifizierungen und Bestandesichte

Ein Parameter zur Beurteilung von Pflanzenbeständen ist die Bestandesdichte. Diese wird oft zeitintensiv gezählt, oder subjektiv prozentual abgeschätzt. Mit Hilfe der berechneten Vegetationsindizes können über Schwellenwerte Klassifizierungen durchgeführt werden. Dabei können die Pixel mit Vegetation erkannt werden und solche, auf denen Boden zu sehen ist. Über die Berechnung von zonalen Statistiken lässt sich anteilig bestimmen wie viel Fläche bewachsen ist. Die damit ermittelte Bestandesdichte bietet neben dem zeitlichen Vorteil auch eine Objektivität, was die Vergleichbarkeit von Flächen oder Boniturzeitpunkten, gegenüber subjektiver Bonitur mehrerer Personen, verbessert.

Unterscheidung von Vegetation und Boden im Kichererbsen-Sortenversuch 2020 (Markus Strathmann, AG Digitalisierung)

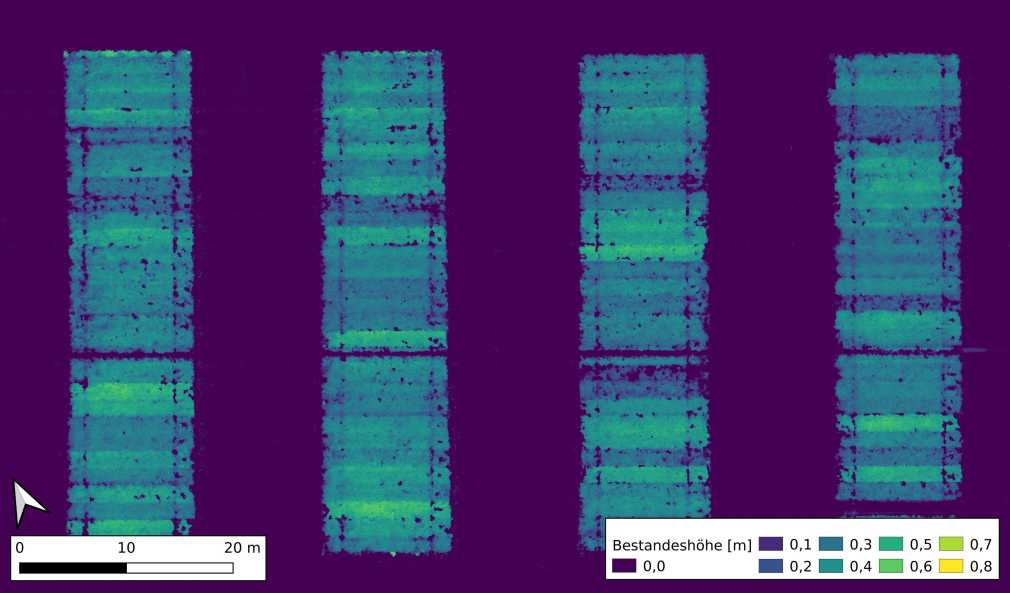

Bestandeshöhe

Die Bestandeshöhe kann mittels Höhenmodell aus Drohnendaten erfasst werden. Dafür ist es notwendig, nach der Aussaat eine

erste Aufnahme zu erstellen, auf der noch keine Vegetation auf der Fläche steht. Das Höhenmodell daraus dient als Referenz

für die anschließenden Aufnahmen. In allen Aufnahmen einer Zeitreihe werden dann Punkte gesucht welche Boden zeigen um die

einzelnen Höhenmodelle über diese Punkte auf das Referenzmodell zu referenzieren. Die Differenz der Modelle zeigt die

Bestandeshöhe.

Visualisierung der Bestandeshöhe, abgeleitet aus dem Höhenmodell des Kichererbsen-Sortenversuches 2020 (Markus Strathmann, AG

Digitalisierung)

Das generierte Wissen und die entwickelten Datenprodukte kommen im Feldversuchswesen am LTZ zum Einsatz. Zusätzlich profitieren auch weitere (Digitalisierungs-)Projekte und Kooperationspartner von den hier gemachten Entwicklungen. Dazu zählen unter anderem die Projekte DiWenkLa, BoniKI, Landwirtschaft 4.0 und Open Forecast. Das LTZ ist auch im Austausch mit anderen Landesanstalten und in verschiedenen Arbeitskreisen zum Thema Drohne aktiv.